Observabilité

Back to glossaryObservabilité : Un guide complet pour comprendre, mettre en œuvre et faire évoluer la visibilité sur votre SI

Quelle est la signification du mot observabilité ?

L’observabilité désigne la capacité à comprendre l’activité de vos systèmes informatiques en analysant les données qu’ils produisent : logs, métriques et traces. L’observabilité vise à sensibiliser les organisations à leur performance numérique en rendant leurs technologies « observables ». Plus qu’un simple concept technique, l’observabilité, qui offre une visibilité approfondie, constitue une capacité stratégique permettant aux organisations de maintenir performance, fiabilité et agilité dans un monde numérique de plus en plus complexe. Grâce à des solutions d’observabilité, les organisations peuvent également mieux comprendre et poursuivre leur transformation numérique, et l’adapter à leur contexte métier.

Dans les systèmes logiciels, l’observabilité fait référence à la manière dont les états internes d’un système peuvent être compris de l’extérieur en les examinant :

- Logs (journaux) – Enregistrements textuels d’événements et de processus discrets au sein d’un système.

- Métriques – Valeurs numériques représentant les performances ou l’état de composants spécifiques.

- Traces – Enregistrements qui suivent le cheminement d’une demande à travers les différents services d’un système distribué.

Ces données permettent aux équipes de détecter, d’étudier et de résoudre rapidement les problèmes, réduisant ainsi le risque d’interruption de service et garantissant des performances optimales aux utilisateurs finaux.

Observer, une évolution par rapport à la supervision traditionnelle

Alors que la supervision répond à la question « le système fonctionne-t-il comme prévu ? », l’observabilité va plus loin, en permettant aux équipes de répondre à la question « Pourquoi cela ne fonctionne-t-il pas ? ».

| Supervision | Observabilité |

| Suivi des modes de défaillance connus | Identification des problèmes inconnus et des causes profondes |

| Réactivité | Proactivité et diagnostic |

| Centrer sur les métriques | Ingestion de métriques, de logs et de traces (télémétrie) |

| Répond à la question « que s’est-il passé ? » | Répond à la question « pourquoi cela s’est-il produit ? ». |

Ce changement est essentiel dans les environnements modernes, qui regroupent des infrastructures hybrides, on-premise et distribués, où les outils de supervision traditionnels risquent d’être insuffisants pour fournir la visibilité et les diagnostics nécessaires pour assurer la résilience du système.

Résumé de la définition

L’observabilité est la pratique qui consiste à collecter, corréler et analyser les données télémétriques des systèmes distribués afin d’obtenir une visibilité approfondie et des informations exploitables sur le comportement et l’état des systèmes.

Pourquoi l’observabilité est-elle importante dans l’informatique moderne ?

Dans les environnements informatiques dynamiques et distribués d’aujourd’hui, l’observabilité n’est plus un luxe, c’est une nécessité. La complexité croissante des systèmes numériques, associée aux attentes de plus en plus grandes des utilisateurs et à des accords de niveau de service plus ambitieux, fait qu’il est impératif de comprendre non seulement ce qui se passe au sein d’un système, mais aussi pourquoi et comment cela se produit.

À mesure que les organisations font évoluer leur infrastructure IT et adoptent des microservices, des conteneurs et des stratégies multi-cloud, l’observabilité devient un catalyseur stratégique du temps de disponibilité, de la performance et des initiatives liées à la transformation digitale.

Les points clés qui démontrent l’importance de l’observabilité

- Une détection proactive des incidents

- L’observabilité permet de détecter rapidement les anomalies avant qu’elles ne se transforment en pannes.

- Elle apporte aux équipes des outils pour approfondir les analyses sur les problèmes potentiels avec un temps de latence minimal.

- Un temps moyen de résolution plus rapide (MTTR)

- La visibilité approfondie raccourcit le cycle de vie des incidents, de la détection à la remédiation.

- L’observabilité réduit les temps d’arrêt coûteux et améliore la satisfaction des utilisateurs et l’expérience client

- Un support aux systèmes complexes et distribués

- Les architectures modernes telles que les microservices, les conteneurs et le serverless exigent une télémétrie corrélée pour un dépannage efficace.

- L’observabilité permet d’unifier les signaux provenant de systèmes multiples en un récit cohérent.

- Un meilleur pilotage des SLA et de la conformité

- C’est un outil qui permet de disposer d’indicateurs de niveau de service (SLI) et de niveaux d’objectifs (SLO)

- C’est également une aide pour les responsables et managers d’ITOps pour démontrer leur conformité et leur responsabilité face aux parties prenantes.

- Des équipes plus efficaces qui développe une culture de l’appropriation

- Les développeurs et les SRE peuvent s’auto-diagnostiquer et s’approprier les performances de leurs services.

- La collaboration est meilleure entre les équipes grâce à des tableaux de bord et des informations partagées.

- La garantie de continuité des activités et une meilleure expérience digitale

- L’observabilité permet de veiller à ce que les outils digitaux fonctionnent de manière fiable sur l’ensemble des canaux.

- La perte de clients , due à la dégradation des performances ou aux pannes de l’IT, est minimisée.

L’observabilité, un nouvel atout stratégique ?

Pour les Tech Leads et les ITOps Managers, l’observabilité présente des avantages stratégiques :

| Objectif stratégique | Contribution à l’observabilité |

| Réduction des temps d’arrêt | Alertes précoces et identification des causes profondes |

| Amélioration de l’efficacité des technologies de l’information | Workflows rationalisés, moins d’outils, automatisation |

| Optimisation de la planification des ressources | Mesures en temps réel pour établir des prévisions de capacité et d’utilisation |

| Support de la transformation digitale | Garantie de la fiabilité et de la souplesse de l’infrastructure |

| Maîtrise des coûts | Elimination de la redondance des outils et réduction des coûts associés aux incidents. |

En fournissant en temps réel des informations exploitables sur l’ensemble des environnements, l’observabilité soutient à la fois les objectifs techniques des équipes IT et les objectifs stratégiques de l’organisation, tels que l’innovation, la satisfaction des clients et la pérennnité du chiffre d’affaires.

Quelle est la différence entre l’observabilité et le monitoring ?

Bien qu’elles soient souvent utilisées de manière interchangeable, l‘observabilité et la supervision ont des objectifs distincts dans les équipes d’exploitation informatiques modernes. Il est essentiel de comprendre la différence pour construire des systèmes résilients et choisir la bonne stratégie d’outillage.

Supervision : mesurer des conditions connues

La supervision informatique est le processus qui consiste à collecter des ensembles prédéfinis de métriques et d’événements pour évaluer les performances du système. Il s’agit en grande partie d’un processus réactif, conçu pour alerter les équipes lorsque des seuils sont franchis ou que des composants deviennent indisponibles.

Les caractéristiques traditionnelles de la supervision sont les suivantes :

- Tableaux de bord et alertes prédéfinis

- Seuils statiques

- Concentration sur les scénarios d’échec connus

- Particulièrement adapté aux environnements stables et monolithiques

Exemple : La supervision vous avertira que l’utilisation de l’UC a dépassé 95 %, mais elle ne vous expliquera pas pourquoi cela s’est produit.

Observabilité d’un système : diagnostiquer ce que l’on ne connait pas

L‘observabilité est une discipline proactive et diagnostique qui se concentre sur la compréhension du pourquoi du comportement du système en analysant les données télémétriques telles que les métriques, les logs et les traces. Elle prend en charge les systèmes complexes et dynamiques dont les modes de défaillance sont inconnus ou imprévisibles.

L’observabilité permet de :

- Explorer les comportements émergents en temps réel,

- Poser des questions ad hoc et obtenir des réponses pertinentes,

- Corréler les données entre les services, les couches et l’infrastructure,

- Découvrir la cause première des incidents sans définition préalable des alertes.

Exemple : L’observabilité permet de retracer une baisse de performance qu’un microservice mal configuré introduit dans le dernier déploiement.

Comparaison entre observabilité et supervision

| Fonctionnalité | Supervision | Observabilité |

| Objectif principal | Alerter sur les problèmes connus | Enquêter sur des problèmes inconnus |

| Focus | Santé du système | Comportement du système |

| Types de données | Métriques (principalement) | Mesures, logs, traces (données télémétriques) |

| Cas d’utilisation | Alerte basée sur des seuils | Analyse des causes profondes, déboggage |

| Approche | Réactive | Proactive et centrée sur le diagnostic |

| Adaptabilité | Conditions prédéfinies | Interrogation dynamique et flexible |

| Livrables | Tableaux de bord et alertes | Perspectives et corrélations |

Plutôt que de remplacer la supervision, l’observabilité l’améliore et l’étend. La supervision est un élément indispensable du stack d’observabilité, en particulier pour les performances en matière de temps de fonctionnement et les alertes.

Pour les équipes informatiques et les responsables techniques qui ont besoin d’une visibilité totale sur l’infrastructure, et pour les responsables informatiques ou ITOps qui ont besoin d’une assurance au niveau du système pour le reporting et l’optimisation des accords de niveau de service, l’observabilité offre une profondeur de vue que la supervision informatique traditionnelle seule ne peut pas fournir, en particulier dans le cas de l’utilisation de plusieurs plates-formes de supervision informatique, source d’angles morts.

Quels sont les trois piliers de l’observabilité ?

L’observabilité repose sur une base communément appelée les trois piliers : métriques, logs et traces. Ces signaux de télémétrie fournissent des perspectives complémentaires sur le comportement du système et constituent le cœur de toute stratégie d’observabilité.

1. Les métriques : l’optique quantitative

Les métriques sont des valeurs numériques qui représentent l’état et/ou les performances d’un système d’information au fil du temps. Elles sont très efficaces, facilement agrégeables et idéales pour piloter les alertes et l’analyse des tendances.

En voici quelques exemples de métriques :

- Utilisation de l’unité centrale et de la mémoire

- Débit et temps de latence des requêtes

- Utilisation des disques d’E/S et du réseau

- Nombre de sessions ou d’utilisateurs actifs

Principaux avantages des métriques :

- Rapides à collecter

- Idéalement conçus pour alimenter les tableaux de bord et les alertes basées sur des seuils

- Utiles pour le capacity planning et la supervision des accords de niveau de service.

Les métriques sont le point de départ de la plupart des analyses des performances, en particulier lorsqu’il s’agit de superviser des KPI tels que la disponibilité ou le MTTR.

2. Les logs: le contexte narratif

Les logs sont des enregistrements textuels horodatés qui décrivent ce qui s’est passé dans un système ou une application. Ils sont souvent non structurés ou semi-structurés et fournissent des informations contextuelles sur les événements.

En voici quelques exemples :

- Journal des succès/échecs d’authentification

- Journal des appels à l’API avec les données utiles des requêtes

- Messages de déboggage spécifiques à l’application

- Erreurs et avertissements du système

Principaux avantages des logs :

- Narration riche et détaillée des événements

- Essentiels pour le dépannage et l’audit

- Analysable aisément pour trouver des modèles

Les logs répondent à la question « que s’est-il passé exactement ? », ce qui constitue une aide précieuse pour l’analyse des causes profondes et les enquêtes de sécurité.

3. Les traces : la feuille de route

Les traces capturent le chemin parcouru par une requête à travers plusieurs composants d’un système distribué. Elles sont essentielles dans les architectures microservices, où une seule action de l’utilisateur peut concerner des dizaines de services.

Chaque trace est constituée d’une série de travées, chacune représentant une unité de travail, comme un appel à une base de données ou une demande d’API.

Principaux avantages des traces :

- Visibilité de bout en bout des transactions

- Identification des goulets d’étranglement et des régressions de performance

- Optimisation de l’expérience utilisateur

Les traces répondent à la question « où le problème s’est-il produit ? » dans les environnements complexes et orientés services. Le traçage permet aux équipes IT de suivre le parcours d’une requête à travers les services distribués, en capturant chaque appel, chaque portée et chaque dépendance. Cette visibilité granulaire est essentielle non seulement pour optimiser les performances, mais aussi pour reconstituer les conditions précises d’un incident. Comprendre le parcours complet d’une requête permet d’accélérer les processus de déboggage en réduisant la portée des causes profondes potentielles, en particulier dans les environnements basés sur les microservices.

Une observabilité unifiée grâce à la télémétrie

Lorsqu’ils sont combinés, les métriques, les logs et les traces fournissent une vue à 360 degrés du comportement du système IT. Cette triangulation permet aux équipes IT et développement de :

- Détecter rapidement les anomalies, même sans règles prédéfinies,

- Établir une corrélation entre les symptômes (par exemple, un pic d’erreurs) et les causes (par exemple, un service mal configuré),

- Réduire le temps passé à passer d’un outil à l’autre et d’une source de données à l’autre.

Dans les stacks d’observabilité avancés, ces sources de télémétrie sont collectées, stockées, corrélées et visualisées au sein d’une interface unique pour une convivialité et une visibilité maximales.

Tableau récapitulatif : Les trois piliers de l’observabilité

| Pilier | Format | Objectif | Points forts |

| Métriques | Séries numériques | Indicateurs quantitatifs de santé | Rapidité, facilité d’alerte, évolutivité |

| Journaux (logs) | Enregistrements de texte | Données descriptives sur les événements | Contexte riche, erreurs détaillées, comportement de l’utilisateur |

| Traces | Chemins hiérarchiques | Vue de la transaction de bout en bout | Cartographie des dépendances, mise en évidence des problèmes de latence |

Chaque pilier contribue de manière unique à une stratégie d’observabilité complète. Ensemble, ils permettent aux équipes informatiques d’observer, comprendre et améliorer les systèmes informatiques modernes.

L’observabilité dans DevOps et SRE (ingénierie de fiabilité des sites )

L’observabilité joue un rôle essentiel dans l’activation des pratiques DevOps et de l’ingénierie de fiabilité des sites (SRE) en offrant la visibilité, les diagnostics et la confiance nécessaires pour déployer le code plus rapidement, en toute sécurité et en continu.

Dans les deux disciplines, le succès se mesure non seulement par le temps de fonctionnement du système, mais aussi par la capacité à détecter et à résoudre rapidement les problèmes, à automatiser les workflows de réponse et à minimiser l’impact sur l’utilisateur. L’observabilité fournit la base de connaissance pour tout cela.

La perspective DevOps

Les équipes DevOps sont chargées de créer, tester, libérer et superviser les applications – souvent au sein de pipelines CI/CD (intégration continue / livraison continue) qui automatisent et accélèrent le déploiement du code.

Avec l’observabilité en place, les équipes DevOps peuvent procéder à des mises en production plus fréquentes tout en maintenant le contrôle et la fiabilité.

L’observabilité prend également en charge la livraison continue en fournissant des boucles de retour d’information en temps réel. Lorsque les développeurs apportent des modifications au code, les données télémétriques offrent un aperçu immédiat de la stabilité, des performances et de l’intégrité des services, réduisant ainsi le risque que des défaillances silencieuses n’atteignent la production.

Ainsi, l’observabilité favorise la confiance et l’autonomie des ingénieurs logiciels, accélérant ainsi l’innovation sans compromettre la fiabilité.

Pour en savoir plus sur la façon dont l’observabilité permet de simplifier les workflows DevOps et renforcer la confiance dans les versions, lisez le guide de Centreon sur l’observabilité dans les environnements DevOps.

Le point de vue du SRE

Les SRE se concentrent sur le maintien de la fiabilité des services et l’application des SLO (objectifs de niveau de service). Ils dépendent de l’observabilité pour :

- Définir et superviser les indicateurs de niveau de service (SLI),

- Automatiser la réponse aux incidents et les analyses a posteriori,

- Détecter les premiers signes de défaillance grâce à la détection des anomalies,

- Construire des systèmes auto-réparateurs en utilisant des signaux d’observabilité.

L’observabilité permet aux SRE de passer d’une attitude visant à éteindre des feux à une approche reposant sur une ingénierie proactive de la fiabilité.

Principaux cas d’utilisation de l’observabilité pour les DevOps/SRE

| Cas d’utilisation | Impact de l’observabilité |

| Validation du pipeline CI/CD | Détecter les régressions, les échecs de déploiement, les problèmes d’environnement |

| Tests de performance | Mesurer les performances réelles sous charge |

| Rétablissement et récupération | Diagnostiquer les causes et l’impact des mauvaises versions |

| Propriété et responsabilité des services | Permettre aux développeurs de superviser leur propre code en production |

Renforcer l’adhésion grâce à l‘observabilité

Au-delà de l’outillage, l’observabilité favorise également une culture d’appropriation, de confiance et de transparence, qui sont des principes fondamentaux de DevOps et de SRE :

- Les développeurs peuvent explorer le comportement de la production sans contrôle d’accès

- Les équipes partagent une couche de télémétrie commune et une même compréhension de la santé

- La résolution des incidents devient collaborative et s’appuie sur des données.

En adoptant l’observabilité dès le début du cycle de développement, les clients réduisent les risques et alignent leurs opérations sur une livraison agile et centrée sur le client.

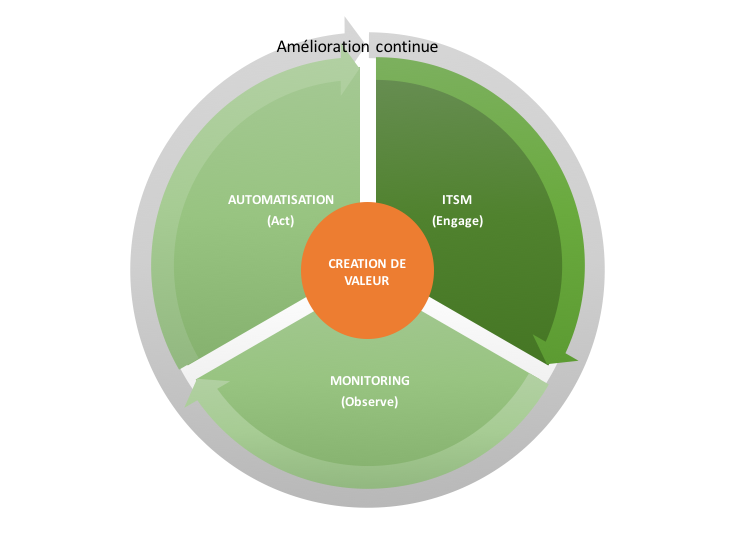

L’observabilité pour les ITOps

Alors que les systèmes digitaux deviennent de plus en plus distribués et complexes, les équipes d’exploitation IT (ITOps) sont soumises à une pression croissante pour maintenir la fiabilité des systèmes, respecter les accords de niveau de service (SLA) et assurer la fluidité de la mise à disposition des services informatiques au fil de l’eau. L’observabilité fournit aux ITOps la visibilité, le contrôle et l’intelligence nécessaires pour exploiter les systèmes critiques en toute confiance.

Contrairement aux DevOps, qui se concentrent sur le développement et la vélocité des versions, les ITOps sont chargés d’assurer la stabilité, la disponibilité et les performances à long terme – en particulier dans les environnements hétérogènes, hybrides ou hérités.

Principaux avantages de l’observabilité pour les ITOps

1. Visibilité opérationnelle sur l’ensemble du stack

- Supervision de l’infrastructure, les applications, les services et les dépendances à partir d’un seul écran,

- Détection de la dégradation des performances, les composants défaillants et/ou les dérives de configuration avant que les utilisateurs ne soient affectés.

2. Prévention des incidents et analyse des causes profondes

- Utilisation de la télémétrie historique et les alertes en temps réel pour détecter les schémas qui signalent des problèmes potentiels,

- Réduction des temps de réponse aux incidents grâce à la corrélation contextuelle entre logs, mesures et traces.

3. Suivi des accords de niveau de service et rapports de conformité

- Alignement des tableaux de bord d’observabilité sur les SLI et SLO critiques pour l’entreprise,

- Meilleure visibilité sur le temps de fonctionnement, la latence et les mesures de performance auprès des parties prenantes.

4. Consolidation des outils et efficacité des processus

- Remplacement des outils de supervision fragmentés par des plateformes d’observabilité unifiées,

- Rationalisation des workflows entre les équipes NOC, SysAdmin et infrastructures.

5. Prise en charge des environnements hybrides et Legacy

- Intégration aux plateformes modernes non-cloud et aux systèmes legacy.

- Visibilité cohérente pendant la transformation numérique sans perte de contrôle des systèmes existants.

Pour les managers IT Ops, l’observabilité n’est pas seulement un atout technique, c’est aussi un moyen stratégique d’assurer la continuité, la responsabilité et la maîtrise des coûts dans le domaine des technologies de l’information.

Comment l’observabilité renforce les équipes ITOps

| Défi | Solution d’observabilité |

| Respecter les accords de niveau de service et éviter les pénalités | Tableaux de bord SLO en temps réel, signaux d’alerte précoce |

| Maintenance des systèmes Legacy et des systèmes non-cloud | Collecte unifiée de données télémétriques dans tous les environnements |

| Diagnostic des régressions de performance | Vues corrélées entre l’infrastructure et les applications |

| Optimisation de la capacité et des prévisions | Analyse des tendances, mesures historiques, prévisions |

| Réduction des temps d’arrêt et des efforts manuels | Automatisation, alertes et détection des causes profondes pouvant faire l’objet d’une action |

En adoptant l’observabilité, les équipes ITOps gagnent en supervision stratégique – ce qui leur permet de prendre des décisions plus rapides, de réduire les risques opérationnels et de contribuer directement au succès des services numériques.

Dans le cadre d’une stratégie d’observabilité, la plateforme de supervision ouverte et extensible de Centreon aide les équipes ITOps à obtenir une visibilité sur l’ensemble du stack, à détecter les problèmes de manière proactive et à assurer la continuité des services dans des environnements complexes.

Quid de l’observabilité à l’ère du cloud ?

À mesure que les entreprises adoptent des architectures cloud-natives, l’observabilité est devenue un pilier essentiel pour la gestion d’environnements complexes et décentralisés. Les outils de supervision traditionnels – conçus pour des infrastructures statiques – ne peuvent pas suivre le rythme du cloud.

De nouveaux défis Cloud qui exigent l’observabilité

Le cloud introduit plusieurs défis opérationnels qui rendent l’observabilité indispensable :

- Des environnements dynamiques : les conteneurs, les pods Kubernetes et les fonctions serverless ont une durée de vie courte et évoluent rapidement.

- Des services décentralisés : les applications sont divisées en microservices qui communiquent entre les régions et les plates-formes.

- La prolifération des outils : la multiplicité des fournisseurs, des API et des systèmes crée une visibilité fragmentée.

- Des modèles de responsabilité partagée : les fournisseurs de cloud supervisent l’infrastructure, mais les performances de l’application restent de votre ressort.

L’observabilité comble ces lacunes en matière de visibilité en collectant et en corrélant la télémétrie dans l’ensemble de l’infrastructure, des plateformes et des applications, quel que soit l’endroit où elles se trouvent.

L’observabilité du cloud en action

L’observabilité du cloud combine la télémétrie de diverses couches du cloud pour offrir une visibilité de bout en bout :

- IaaS (Infrastructure as a Service) : mesures et logs des machines virtuelles, des réseaux et du stockage.

- PaaS (Platform as a Service) : traces des bases de données gérées, des conteneurs et des services d’exécution.

- SaaS et API : supervision de l’expérience utilisateur et aperçu de la dépendance des tiers.

Pour les organisations qui utilisent des plateformes d’orchestration de conteneurs comme Kubernetes, l‘intégration de supervision de Kubernetes de Centreon offre une visibilité détaillée sur la santé des clusters, les charges de travail et l’utilisation des ressources – garantissant une observabilité cloud-native à l’échelle.

Principaux avantages :

- Détecter les pannes et les goulets d’étranglement en temps réel,

- Diagnostiquer les erreurs de configuration dans la mise à l’échelle automatique et l’équilibrage de la charge,

- Comprendre les implications financières liées à l’utilisation et à l’efficacité des ressources.

Apprenez à superviser efficacement l’infrastructure cloud.

Observability As A Service (OaaS)

Pour simplifier la mise en œuvre de l’observabilité, de nombreux fournisseurs proposent désormais l’observabilité en tant que service, ce qui permet aux organisations de :

- Déverser la collecte, la corrélation et la visualisation des données sur une plateforme gérée,

- Éliminer les frais d’infrastructure pour les outils d’observabilité,

- Tirer parti de l’apprentissage automatique intégré pour la détection des anomalies.

Les fonctionnalités OaaS les plus répandues sont les suivantes :

- Tableaux de bord unifiés pour l’infrastructure hybride/multi-cloud,

- Sources de données et agents pré-intégrés,

- Alerte en temps réel et corrélation des incidents,

- Prise en charge d’OpenTelemetry en tant que norme pour l’ingestion de données de télémétrie.

Vers une observabilité unifiée des environnements

Dans les scénarios hybrides et non-cloud, une couche d’observabilité unifiée garantit une visibilité cohérente à travers :

- Centres de données On-premises,

- Charges de travail des clouds publics et privés,

- Plateformes d’orchestration de conteneurs (Kubernetes, Docker Swarm),

- Environnements serverless (AWS Lambda, Azure Functions, Google Cloud Functions).

Cette unification permet aux profils techniques tels que les responsables supervision, les Tech Leads et les ITOps Managers de:

- Superviser et comparer les charges de travail quel que soit l’environnement,

- Prendre des décisions éclairées sur l’allocation des ressources et la stratégie Cloud,

- Assurer la continuité du service, même au sein d’une infrastructure hétérogène.

Plateformes et outils d’observabilité

Pour tirer pleinement parti des avantages de l’observabilité, les entreprises se tournent vers des plateformes d’observabilité, qui ingèrent, traitent, analysent et visualisent les données télémétriques dans des systèmes complexes et distribués. Ces plateformes constituent la base des stratégies d’observabilité dans les environnements informatiques modernes.

Qu’est-ce qu’une plateforme d’observabilité ?

Une plateforme d’observabilité est un système centralisé qui consolide les métriques, les logs et les traces provenant de diverses sources et qui permet aux équipes de :

- Visualiser les données à l’aide de tableaux de bord et de rapports,

- Mettre en place d’alertes intelligentes et détection d’anomalies,

- Corréler des événements entre les applications, l’infrastructure et les services,

- Accélérer la réponse aux incidents et l’analyse des causes profondes.

Contrairement aux outils de supervision traditionnels, les plateformes d’observabilité sont agnostiques en matière de télémétrie et sont conçues pour permettre un déploiement à l’échelle, flexible et intelligent.

Principales caractéristiques des plateformes d’observabilité

| Fonctionnalité | Description |

| Ingestion de données (signaux) multiples | Collecte des métriques, des logs, des traces, des événements et des données télémétriques |

| Corrélation des données | Lien entre les anomalies et les composants afin de mettre en évidence les causes profondes |

| Tableaux de bord et rapports | Visualisations unifiées pour les équipes et les parties prenantes |

| Informations alimentées par l’IA/ML | Alerte prédictive, détection de modèles, détection d’anomalies |

| Prêt-à-l’emploi pour l’intégration | Lien avec les pipelines DevOps, les outils ITSM, les API et les fournisseurs de cloud |

| Évolutivité et flexibilité | Gestion de grands volumes de données à travers des configurations hybrides ou multi-cloud |

De nombreuses solutions d’observabilité intègrent désormais l’IA (Intelligence Artificielle) pour automatiser la détection des anomalies, prédire les problèmes potentiels et recommander des solutions de remédiation.

En apprenant à partir de modèles de télémétrie historiques, ces plateformes aident à mettre en avant ce qui est vraiment important pour les ingénieurs logiciels et les équipes SRE. L’observabilité pilotée par l’IA permet d’interpréter les détails au niveau du code dans le contexte plus large de l’entreprise – en reliant les anomalies techniques à l’impact sur les utilisateurs ou à la perte de revenus.

L’IA et le machine learning dans l’observabilité

Les plateformes d’observabilité modernes s’appuient plus que jamais sur l’IA (Intelligence artificielle) pour gérer l’échelle et la complexité des systèmes distribués. L’IA permet de traiter de vastes volumes de données télémétriques (mesures, logs, traces) et d’extraire des modèles significatifs en temps réel.

Grâce à l’IA, les outils d’observabilité peuvent :

- Détecter les anomalies sans s’appuyer sur des seuils statiques,

- Prévoir les incidents avant qu’ils n’affectent les utilisateurs,

- Hiérarchiser les alertes en fonction de l’impact sur l’activité et de la gravité,

- Recommander des mesures correctives automatisées pour réduire les temps d’arrêt.

En intégrant l’IA dans les workflows d’observabilité, les équipes IT sont mieux équipées pour réduire l’alerte fatigue, résoudre les incidents plus rapidement et améliorer la résilience opérationnelle globale. Pour les responsables ITOps, l’IA contribue également à la maîtrise des coûts, au respect des SLA et à la maintenance prédictive, ce qui en fait un atout puissant dans les stratégies d’infrastructure modernes.

Les environnements de télémétrie devenant de plus en plus complexes, l’IA devient essentielle non seulement pour l’analyse, mais aussi pour transformer les données brutes en informations exploitables.

Observabilité unifiée : Une approche centrée et unique

La prolifération des outils devenant un problème majeur, de nombreuses organisations informatiques visent une observabilité unifiée – une stratégie qui consolide les signaux d’observabilité dans une plateforme unique :

- Réduction des silos et des outils en double,

- Optimisation de l’onboarding et l’adoption par les équipes,

- Amélioration de la visibilité et de la collaboration au sein de l’équipe.

Cette unification s’aligne directement sur des objectifs stratégiques tels que la maîtrise des coûts, le développement des compétences et l’optimisation des processus.

Autant de préoccupations essentielles pour les décideurs tels que les DSI ou des ITOps Managers.

Observabilité des applications et de l’infrastructure

Une véritable observabilité nécessite une visibilité, à chaque couche de l’IT, des fonctions au niveau du code à l’infrastructure physique ou virtuelle qui les supporte. Cela inclut à la fois l’observabilité des applications et l’observabilité de l’infrastructure, chacune offrant une perspective distincte mais complémentaire.

Observabilité des applications

L’observabilité des applications se concentre sur le comportement et la performance des applications, en particulier, dans les architectures complexes comme les microservices et les fonctions serverless. Elle vise à garantir que les applications répondent aux attentes des utilisateurs en matière de disponibilité, de réactivité et de fiabilité.

Capacités clés :

- Traçabilité des transactions dans les microservices,

- Supervision de la latence des points d’extrémité de l’API,

- Suivi des erreurs et enregistrement des exceptions,

- Mesures de l’expérience utilisateur, telles que le temps de chargement des pages ou la réactivité de l’application,

- Diagnostics au niveau du code pour isoler la cause première.

Grâce à l’observabilité des applications, les équipes de développement peuvent détecter rapidement les régressions, débogguer les systèmes en direct et optimiser les performances avant que les problèmes n’affectent les utilisateurs.

Observabilité de l’infrastructure

L’observabilité de l’infrastructure consiste à superviser les composants physiques et virtuels qui prennent en charge les charges de travail des applications. Il s’agit notamment de:

- Serveurs et machines virtuelles

- Systèmes de stockage et bases de données

- Conteneurs et outils d’orchestration (par exemple, Kubernetes).

- Réseaux, pare-feu et load balancers

Les principaux indicateurs et signaux sont les suivants:

- Utilisation de CPU, de la mémoire et du disque,

- Débit du réseau et perte de paquets,

- Événements du cycle de vie du conteneur,

- Santé et disponibilité des éléments d’infrastructure.

L’observabilité de l’infrastructure aide les équipes IT et les Tech Leaders à maintenir la disponibilité des systèmes, à faire respecter les accords de niveau de service et à gérer de manière proactive la capacité et la mise à l’échelle.

Pourquoi combiner observabilité des applications et de l’infrastructure ?

Une observabilité cloisonnée conduit à des angles morts et à des retards dans la résolution des incidents.

En corrélant la télémétrie au niveau de l’application et de l’infrastructure, les équipes bénéficient de :

- La capacité à remonter les problèmes des utilisateurs jusqu’aux causes de l’infrastructure,

- Une image complète du système,

- Un triage et une réponse plus rapides en cas d’incident,

- Une amélioration de la collaboration interfonctionnelle.

Cela est particulièrement important dans les environnements hybrides ou multi-cloud, où la propriété et la visibilité sont souvent distribuées.

Cas d’utilisation (exemple)

| Cas d’utilisation | Ce que révèle l’observabilité de l’application | Ce que révèle l’observabilité de l’infrastructure |

| Lenteur de l’encaissement dans l’application de commerce électronique | Goulot d’étranglement dans le service de paiement (via la trace) | Saturation du processeur sur l’hôte du conteneur |

| Violation de l’accord de niveau de service pour une plateforme SaaS B2B | Supervision des taux de latence et d’erreur des principales API | Latence du réseau dans une région du cloud |

| Sur des ressources après le lancement d’un produit | Pics d’utilisation du frontend révélés par les mesures de l’utilisateur | pas de déclenchement de la mise à l’échelle automatiquement en raison d’une mauvaise configuration |

| Incident de sécurité ou comportement suspect | Modèles de connexion inhabituels ou échecs d’authentification à l’API | Pics de trafic inattendus, balayages de ports |

Tous les membres de l’équipe IT en bénéficient :

- Les responsables techniques ont besoin de connaissances techniques approfondies pour résoudre les problèmes dans l’ensemble du stack.

- Les responsables ITOps recherchent une observabilité au niveau du système pour garantir la performance, démontrer la conformité et soutenir la transformation digitale.

De la donnée d’observabilité à des informations directement actionnables

La collecte de données télémétriques n’est que la première étape. La véritable valeur de l’observabilité réside dans la transformation des données brutes en informations contextualisées et exploitables qui permettent aux équipes de prendre des décisions éclairées et résoudre les problèmes rapidement.

Qu’est-ce que les données télémétriques ?

La télémétrie désigne la collecte et la transmission automatisées de données provenant de systèmes logiciels et d’infrastructures. C’est le carburant qui alimente l’observabilité.

La télémétrie comprend :

- Métriques : données quantitatives dans le temps (par exemple, taux de requêtes, utilisation de la mémoire)

- Logs (journaux) : enregistrements lisibles par l’homme d’événements (par exemple, erreurs, transactions)

- Traces : chronologie des événements montrant le flux des demandes à travers les services

- Événements : changements d’état ou conditions déclenchés au sein des systèmes

- Signaux personnalisés : KPIs spécifiques au business, utilisation des fonctionnalités, etc.

La télémétrie est le « signal brut ». L’observabilité transforme ce signal pour qu’il soit compris.

Des données brutes à une vraie visibilité : le pipeline de l’observabilité

Le passage de la data aux indicateurs se fait généralement en plusieurs étapes :

- Ingestion

- Les données sont collectées à partir d’applications, d’infrastructures, de conteneurs, d’API, etc.

- Souvent par le biais d’agents, de SDK ou d’API (par exemple, OpenTelemetry)

- Normalisation et enrichissement

- Les logs et les mesures sont structurés, étiquetés et horodatés.

- Le contexte est ajouté (par exemple, le nom du service, la version de déploiement, l’identifiant de l’utilisateur).

- Corrélation et contextualisation

- Les mesures, les logs et les traces sont connectés entre les services et les couches.

- Cela permet l’analyse des causes profondes grâce à la mise en correspondance des modèles et des dépendances.

- Visualisation et rapports

- Les tableaux de bord et les cartes thermiques affichent la santé du système en temps réel.

- Les performances SLO/SLI peuvent être suivies pour assurer la conformité.

- Alertes et automatisation

- Des règles ou des modèles IA/ML détectent les anomalies ou les dépassements de seuil.

- Des alertes, des tickets, des workflows d’auto-remédiations sont déclenchés.

La puissance d’une data directement exploitable

Ce qui distingue l’observabilité de la supervision brute, c’est la capacité d’agir sur ce qui est observé. Des informations actionnables cela signifie :

- Moins de faux positifs : alertes déclenchées uniquement lorsque le contexte justifie une action

- MTTR plus court : identification rapide de la cause première et résolution de l’incident

- Une meilleure planification des ressources : analyse des tendances permettant de déterminer l’échelle et la capacité

- Amélioration de l’expérience de l’utilisateur : connaissance en temps réel des problèmes de performance

Pour les responsables techniques, les informations réduisent le temps d’investigation et les diagnostics manuels.

Pour les ITOps Managers, elles permettent le suivi des KPI, le reporting des SLA et l’optimisation des coûts informatiques.

L’observabilité devient encore plus précieuse lorsque la télémétrie est interprétée dans son contexte Métier, en reliant le comportement de l’infrastructure aux résultats des clients, à la performance financière ou aux engagements de niveau de service.

Par exemple, un pic de latence dans une base de données n’est pas seulement un problème technique ; c’est un obstacle potentiel à la réussite des transactions ou au respect des accords de niveau de service. La contextualisation des données d’observabilité permet aux équipes techniques et aux chefs d’entreprise d’aligner les priorités et les actions.

L’observabilité en pratique

Imaginons qu’une plateforme de commerce électronique connaisse une augmentation des échecs au niveau de son checkout :

- Mesure : augmentation du nombre de transactions échouées par minute

- Log : apparition des événements « Payment gateway timeout » dans les logs du backend

- Trace : Durée lente de l’appel à l’API du service de paiement

- Indicateur : Une modification récente de la configuration du délai de réessai provoque une surcharge du service.

La pile d’observabilité permet un diagnostic rapide, étayé par des données et un retour en arrière ou une correction en quelques minutes, ce qui préserve à la fois l’expérience de l’utilisateur et le chiffre d’affaires.

En transformant les données télémétriques en informations exploitables, l’observabilité donne aux équipes une réalité partagée, ancrée dans les données et alignée sur les résultats de l’entreprise.

Bonnes pratiques pour développer l’observabilité

La mise en œuvre de l’observabilité ne se limite pas au déploiement d’outils : il s’agit d’établir un cadre systématique qui s’aligne sur les objectifs techniques et commerciaux. Les pratiques d’observabilité réussies reposent sur l’alignement interfonctionnel, la cohérence des données et la maturité des processus.

Voici les principales bonnes pratiques pour construire et mettre à l’échelle l’observabilité dans les environnements informatiques modernes :

1. Concevoir les systèmes en pensant observabilité dès le départ

- Intégrer l’observabilité dans l’architecture des systèmes et les cycles de développement des logiciels (SDLC).

- Mettre en place des applications avec OpenTelemetry ou des normes similaires

- Traiter la télémétrie comme un citoyen de première classe dans les pipelines DevOps.

Les systèmes conçus pour être observables sont plus faciles à exploiter, à déboguer et à faire évoluer.

2. Adopter les trois piliers de manière holistique

- Collecter et mettre en corrélation les mesures, les logs et les traces dans les différents environnements.

- Éviter les silos de piliers – intégrer les données dans des vues unifiées.

- Ne pas se reposer pas sur un seul pilier (par exemple, les mesures uniquement).

Une stratégie de télémétrie équilibrée permet d’établir des diagnostics complets.

3. Instaurer une culture de l’observabilité au sein de l’équipe

- Encourager la collaboration entre les équipes Dev, Ops et SRE.

- Mettre en place des tableaux de bord, des alertes et des canaux d’incidents partagés.

- Créer des plans d’exécution et des analyses a posteriori qui font référence aux données télémétriques.

L’observabilité fonctionne mieux lorsque les équipes partagent la responsabilité de la santé du système.

4. Donner la priorité aux KPIs centrés sur le business

- Relier les données d’observabilité aux données business (par exemple, taux de conversion, respect des accords de niveau de service).

- Suivre les indicateurs de niveau de service (SLI) qui reflètent l’expérience de l’utilisateur.

- Utiliser la télémétrie pour améliorer les indicateurs relatifs aux clients, et pas seulement les statistiques d’infrastructure.

L’alignement de l’observabilité sur la valeur commerciale est essentiel pour obtenir le soutien de la direction et le budget.

5. Commencer modestement, augmenter intelligemment

- Commencer par les services essentiels et les développer de manière itérative.

- Se concentrer sur les signaux de grande valeur et les alertes exploitables.

- Ne pas surcharger pas les équipes avec des données et des alertes inutiles.

La clarté et la concentration l’emportent sur la complexité et la surcharge.

6. Normaliser les balises, les étiquettes et les métadonnées

- Appliquer des conventions de dénomination cohérentes dans tous les environnements.

- Utiliser des étiquettes pour organiser la télémétrie par service, région, équipe, etc.

- Aider au filtrage, à la recherche, à la corrélation et à l’attribution des coûts.

La cohérence permet d’accélérer les enquêtes et de faciliter la mise à l’échelle.

7. Tirer parti de l’automatisation et de l’apprentissage automatique

- Utiliser l’IA/ML pour la détection des anomalies, la suppression du bruit et la hiérarchisation des alertes.

- Automatiser les tâches répétitives telles que l’acheminement des alertes, la création de tickets, voire la remédiation.

- Réduire la charge de travail opérationnelle et accroître l’agilité.

L’automatisation accroît la valeur de l’observabilité et favorise l’efficacité de l’IT.

8. Superviser l’observabilité elle-même

- Maintenir les systèmes d’observabilité à un niveau élevé de disponibilité et de sécurité.

- S’assurer que les pipelines de télémétrie sont supervisés et capables de basculer.

- Vérifier périodiquement l’intégrité des données et la latence.

Les outils d’observabilité sont essentiels à la mission et doivent également être observables.

Un cadre de maturité pour l’observabilité

Les organisations peuvent évaluer leur capacité d’observation à l’aide d’un modèle de maturité :

| Niveau | Caractéristiques |

| De base | Supervision isolée, logs limités, pas de traçage |

| Développement | Corrélation manuelle, utilisation du tableau de bord, début de standardisation |

| Maîtrise de la langue | Télémétrie complète, vues unifiées, alertes automatisées |

| Avancé | Adoption par l’ensemble de l’équipe, KPIs business, insights pilotés par le ML. |

| Optimisé | Pleinement intégré à la stratégie, à l’analyse prédictive, aux systèmes d’autoréparation |

Ce cadre aide les responsables IT/ITOps et les chefs d’entreprise à suivre les progrès et à justifier les investissements dans les capacités d’observabilité.

Observabilité : Exemples et cas d’utilisation

L’observabilité n’est pas un concept théorique – c’est une fonctionnalité pratique qui permet aux organisations de maintenir la fiabilité des systèmes, d’améliorer les performances et de soutenir la transformation digitale. Vous trouverez ci-dessous des cas d’utilisation et des exemples qui démontrent sa valeur dans les contextes IT et Business.

1. Plate-forme e-commerce : un abandon de paniers trop élevé

Scénario : Un grand détaillant en ligne observe un pic dans l’abandon des paniers d’achat.

- Ce que dit de la télémétrie :

- Les mesures révèlent une baisse des transactions de paiement réussies.

- Les logs font état d’un nombre croissant d’erreurs de dépassement de délai de la part du service de paiement.

- Les traces identifient un goulot d’étranglement au niveau des dépendances, introduit lors d’un déploiement récent.

- Ce qui se passe concrètement :

- Les ingénieurs identifient rapidement un délai d’attente de l’API mal configuré.

- Un retour en arrière est lancé et la reprise des ventes commence en quelques minutes.

L’observabilité permet un triage rapide, minimise les pertes de revenus et protège l’expérience de l’utilisateur.

2. Services financiers : baisse de la disponibilité inscrite dans les SLA

Scénario : Une application bancaire doit maintenir une disponibilité de 99,99 % pour ses services de base.

Ce que dit de la télémétrie :

- Les tableaux de bord SLO indiquent que les temps de réponse dépassent les seuils.

- Cause première : dégradation des performances des connexions aux bases de données en raison de l’échec d’un correctif.

Ce qui se passe concrètement :

- L’observabilité permet de lancer des alertes précoces et de générer des tickets automatisés.

- La violation de l’accord de niveau de service est documentée et un contrôle compensatoire est appliqué de manière proactive.

L’observabilité aide les responsables ITOps à démontrer la conformité réglementaire et l’assurance SLA.

3. Fournisseur SaaS : optimisation des dépenses liées au cloud

Scénario : Une société SaaS cherche à réduire les coûts du cloud tout en maintenant ses performances.

Ce que dit de la télémétrie :

- Les métriques et les logs montrent un surprovisionnement des ressources sur plusieurs clusters Kubernetes.

- Le traçage révèle les services sous-utilisés avec une interaction minimale de l’utilisateur

Ce qui se passe concrètement :

- Les équipes réduisent l’échelle des ressources pendant les heures creuses à l’aide de stratégies de mise à l’échelle automatique.

- Les économies sont quantifiées et communiquées aux services financiers et opérationnels.

L’observabilité, dans ce cas, favorise à la fois la performance technique et l’efficacité commerciale.

4. Industrie : maintenance préventive

Scénario : Un fabricant exploite des machines connectées à l’IoT qui doivent fonctionner 24 heures sur 24 et 7 jours sur 7.

Ce que dit de la télémétrie :

- Les mesures mettent en évidence les signes précoces de stress thermique sur les composants du moteur.

- Les logs indiquent une augmentation des taux d’erreur dans le micrologiciel de l’appareil.

Ce qui se passe concrètement :

- La maintenance est programmée avant que l’équipement ne tombe en panne.

- Les temps d’arrêt non planifiés évités se traduisent par un retour sur investissement élevé.

L’observabilité permet d’obtenir des informations prédictives et d’assurer la continuité des opérations.

5. Service public : supervision des services numériques pour les usagers

Scénario : Une collectivité publique fournit des services en ligne aux citoyens avec des exigences strictes en matière de disponibilité.

Ce que dit de la télémétrie :

- Les données de traçage montrent des retards de performance lors des opérations de connexion et de téléchargement de fichiers.

- Les logs et les mesures correspondants mettent en évidence la latence du stockage et les certificats SSL expirés.

Ce qui se passe concrètement :

- L’équipe remédie rapidement aux problèmes et partage les rapports d’observabilité avec les parties prenantes.

- La confiance des utilisateurs est maintenue et les accords de niveau de service internes sont respectés.

L’observabilité facilite la transparence et l’assurance des services critiques.

Résumé des cas d’utilisation par domaine

| Secteurs | Application de l’observabilité |

| Commerce électronique | Diagnostic des transactions, protection des revenus |

| Services financiers | Suivi des accords de niveau de service, rapports de conformité |

| SaaS et technologie | Optimisation des coûts, accélération du DevOps, etc. |

| Industrie | Performance des actifs, maintenance prédictive |

| Secteur public | Fiabilité du service numérique, rapports aux parties prenantes |

Ces exemples montrent que l’observabilité n’est pas seulement une question de données, mais qu’il s’agit d’utiliser ces données pour prendre des décisions plus rapides et plus intelligentes qui protègent l’entreprise, optimisent les ressources IT et améliorent la satisfaction des clients.

Défis de l’observabilité et tendances futures

Alors que l’observabilité passe d’une pratique de niche à une discipline courante, les organisations sont confrontées à de nouveaux défis et doivent se préparer aux tendances émergentes qui façonneront son avenir. Il est essentiel de comprendre ces dynamiques pour élaborer une stratégie d’observabilité évolutive et à l’épreuve du temps.

Défis communs dans l’adoption de l’observabilité

Malgré ses promesses, les initiatives en matière d’observabilité se heurtent souvent à des obstacles :

1. La prolifération des outils et la fragmentation des données

- De nombreuses équipes utilisent des outils de supervision, de journalisation et de traçage disparates et hétérogènes, sans aucune intégration.

- Il en résulte des lacunes en matière de visibilité et des diagnostics cloisonnés.

2. L’alerte fatigue

- Les systèmes mal réglés génèrent des alertes excessives (mode sapin de Noël).

- Les équipes peuvent négliger des incidents réels en raison d’un trop grand nombre d’alertes.

3. Les lacunes en matière de compétences et un cloisonnement des équipes

- Il existe un manque de formation aux normes de télémétrie (par exemple, OpenTelemetry).

- Il y a une difficulté à aligner Dev, Ops et SRE sur une stratégie unifiée.

4. Coût et volume des données

- Le stockage à grande échelle de données télémétriques à haute cardinalité peut s’avérer coûteux.

- L’équilibre entre la profondeur d’observation et le budget est une préoccupation commune.

5. Résistance au changement

- La crainte d’une perturbation des opérations peut bloquer le projet.

- L’aversion au risque face aux nouveaux outils et aux changements d’architecture peut être un frein.

Les responsables ITOps doivent aborder ces questions de manière stratégique afin d’offrir une valeur et une adoption cohérentes dans l’ensemble de l’organisation.

Les grandes tendances qui façonnent l’avenir de l’observabilité

1. Montée en puissance de standards plus ouverts (par exemple, OpenTelemetry)

- Instrumentation et portabilité neutres par rapport aux fournisseurs

- Cohérence entre les outils et les environnements

2. Observabilité par l’IA

- Détection des anomalies et analyse des causes profondes grâce à l’apprentissage automatique

- Priorité aux alertes et réduction du bruit grâce à des algorithmes intelligents

3. Observabilité renforcée

- Introduction de la télémétrie plus tôt dans les pipelines de développement

- Aide à la vente et à l’optimisation des performances avant la production

4. Observability-as-Code

- Définition la configuration de la télémétrie à l’aide de code (YAML, Terraform, etc.)

- Intègration de l’observabilité dans les workflows de CI/CD.

5. Plates-formes d’observabilité unifiées

- Consolidation des outils dans des plates-formes de bout en bout

- Corrélation entre les mesures, les logs, les traces et les événements.

6. Observabilité au service des indicateurs métiers

- Réduction du fossé entre la télémétrie technique et les KPIs de l’entreprise

- Mesure de l’expérience utilisateur, des taux de conversion, du coût du service, etc.

Considérations stratégiques pour l’avenir

| Domaine d’intervention | Objectif stratégique |

| Intégration | Éliminer les silos, réduire le chevauchement des outils |

| Automatisation | Renforcer la réponse aux incidents, réduire la charge de travail |

| Flexibilité | Prendre en charge les charges de travail hybrides, cloud et edge. |

| Sécurité et conformité | Pistes d’audit, gouvernance des données, cryptage |

| Efficacité budgétaire | Optimiser les coûts de rétention et d’ingestion des données |

Pour les responsables techniques, l’avenir réside dans une observabilité simplifiée, automatisée et adaptée aux développeurs.

Pour les responsables IT ou ITOps, elle est synonyme d’évolutivité, de maîtrise des coûts et de valeur stratégique des investissements dans l’observabilité.

Comment Centreon contribue-t-il à l’observabilité ?

Centreon joue un rôle essentiel au sein de l’écosystème de l’observabilité en offrant une visibilité approfondie et en temps réel de l’infrastructure IT, et en s’intégrant de manière transparente aux piles d’observabilité.

Centreon offre aux organisations – en particulier celles qui gèrent des environnements SI hybrides complexes – une base solide pour l’observabilité grâce à son :

- Des capacités de supervision étendues

- Une architecture ouverte

- Une intégration avec les pipelines de télémétrie

- Des tableaux de bord et alertes puissants

Les fonctionnalités clés de Centreon qui soutiennent l’observabilité

| Capacité | Valeur d’observabilité |

| Supervision complète de l’infrastructure | Visibilité du stack : serveurs, réseaux, cloud, conteneurs. |

| Alertes et seuils en temps réel | Détection précoce des anomalies et prévention des incidents |

| Auto-Découverte et templates | Déploiement plus rapide et observabilité à grande échelle |

| Corrélation des événements et visualisation des causes profondes | MTTR plus rapide et compréhension contextuelle des problèmes du système |

| Tableaux de bord personnalisables et visualisation SLO | Des rapports clairs pour les acteurs métiers et opérationnels |

Centreon permet aux équipes informatiques d’observer 100 % de leur infrastructure, d’éliminer les angles morts et de détecter rapidement les dégradations de performance.

Centreon complète les autres solutions d’observabilité en apportant des données de supervision fiables et structurées. Il est ainsi plus facile pour les organisations et les entreprises d’unifier leurs outils au sein d’une plateforme unique qui mêle les mesures d’infrastructure et les informations sur les applications, permettant ainsi une stratégie d’observabilité plus complète et mieux alignée sur les besoins de l’entreprise.

Comme le souligne Centreon, il n’y a pas de stack d’observabilité Business sans supervision connectée, et sa plateforme fournit cette couche de connectivité fondamentale.

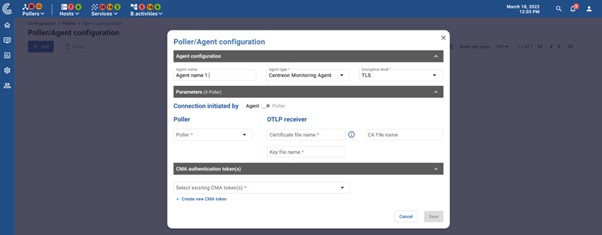

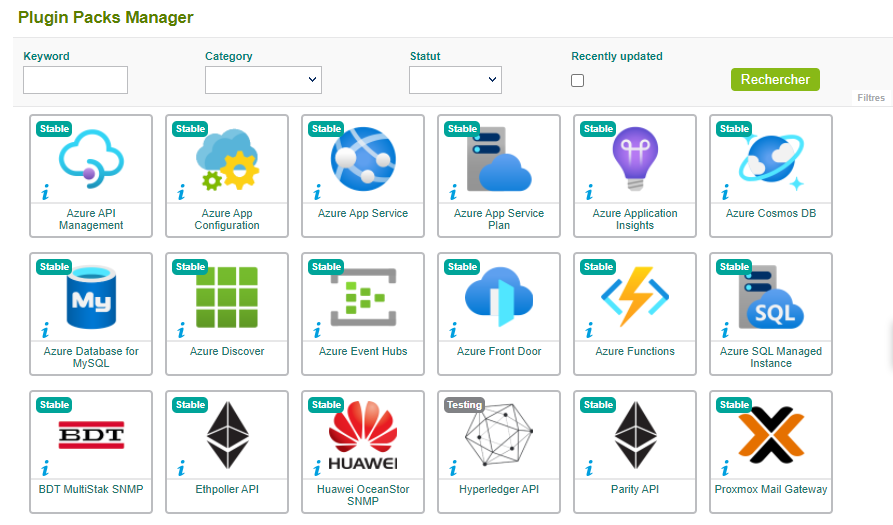

Des intégrations parfaites avec les stacks d’observabilité

Centreon est conçu pour l’interopérabilité, permettant aux organisations d’enrichir leur pratique de l’observabilité grâce à l’intégration de la solution de supervision avec les :

- Systèmes de gestion des logs (par exemple, ELK stack, Splunk)

- Cadres de traçage (par exemple, collecteurs OpenTelemetry)

- Plateformes multi-cloud (par exemple, AWS CloudWatch, Azure Monitor)

- Outils d’ITSM et de réponses aux incidents (par exemple, ServiceNow, PagerDuty)

Ces intégrations garantissent que Centreon apporte des données de supervision structurées et normalisées qui peuvent être ingérées dans des pipelines d’observabilité plus larges.

Explorer :

Cas d’utilisation – Centreon et Observabilité

La valeur de Centreon pour les Tech Leads et les ITOps Managers

Voici comment Centreon s’inscrit dans l’écosystème plus large de l’observabilité :

- Pour les Tech Leads :

Centreon offre une profondeur technique et une précision de supervision qui lui permettent d’instrumenter efficacement les systèmes, de réduire la fatigue liée aux alertes et de maintenir la visibilité dans divers environnements. - Pour les responsables ITOps :

Centreon contribue à la réalisation d’objectifs stratégiques tels que la garantie des accords de niveau de service (SLA), l’optimisation des équipes IT et l’optimisation des coûts d’exploitation, en fournissant une couche fiable au sein d’une organisation axée sur l’observabilité.

Prêt à étendre votre observabilité ?

Centreon aide les équipes informatiques à superviser tout et partout et constitue un élément puissant de votre architecture d’observabilité.

Prochaines étapes :

- En savoir plus sur les fonctionnalités de Centreon.

- Obtenez une démonstration personnalisée de ce qu’est Centreon et de la manière dont il pourrait fonctionner pour vous.

FAQ – Questions fréquemment posées sur l’observabilité

Vous avez d’autres questions sur l’observabilité ? Vous n’êtes pas seul. Nous avons rassemblé ci-dessous les réponses aux questions les plus courantes que se posent les professionnels de l’informatique, les développeurs et les responsables ITOps lorsqu’ils explorent les stratégies, les outils et les meilleures pratiques en matière d’observabilité.

Qu’est-ce que l’observabilité dans le DevOps ?

Dans la démarche DevOps, l’observabilité soutient la livraison continue et l’excellence opérationnelle en fournissant un aperçu en temps réel du comportement des systèmes en production. Elle permet aux équipes de décaler la supervision informatique des performances, de détecter les régressions à un stade précoce et de prendre en charge une réponse plus rapide aux incidents, tout en favorisant la collaboration entre les équipes de développement et d’exploitation.

Qu’est-ce que l’observabilité du cloud ?

L’observabilité du cloud fait référence à la capacité de superviser, d’analyser et d’obtenir des informations sur les applications et l’infrastructure s’exécutant dans des environnements cloud – qu’ils soient publics, privés ou hybrides. Elle comprend la collecte et la corrélation de la télémétrie des conteneurs, des fonctions multi-cloud, des machines virtuelles et des services cloud-native pour garantir les performances, la fiabilité et la conformité sur l’ensemble des systèmes distribués.

Qu’est-ce que l’observabilité des applications ?

L’observabilité des applications est la pratique consistant à superviser l’état interne et les performances des applications logicielles. Elle se concentre sur la télémétrie liée à l’exécution du code, à la latence de l’API, au comportement de l’utilisateur et au suivi des erreurs. Grâce à l’observabilité des applications, les équipes peuvent suivre le comportement des requêtes individuelles, identifier les goulets d’étranglement et optimiser l’expérience de l’utilisateur final.

Comment mettre en œuvre l’observabilité ?

La mise en œuvre de l’observabilité commence par l’instrumentation des systèmes pour collecter des données de télémétrie (logs, mesures et traces) à l’aide d’agents, de SDK ou de normes ouvertes comme OpenTelemetry. Ensuite, il faut centraliser ces données dans une plateforme unifiée, définir des indicateurs de niveau de service (SLI), définir des alertes et créer des tableaux de bord pour la visualisation. Enfin, promouvoir une culture de l’observabilité au sein des équipes pour garantir l’adoption et la collaboration.

Qu’est-ce qu’un outil d’observabilité ?

Les outils d’observabilité sont des plateformes et des services utilisés pour collecter, analyser et visualiser les données de télémétrie. Ils prennent généralement en charge l’ingestion de métriques, de logs et de traces et offrent des fonctionnalités telles que l’alerte, le tableau de bord, l’analyse des causes profondes et la corrélation entre les systèmes distribués.

Comment fonctionne l’observabilité ?

L’observabilité fonctionne en collectant des données de télémétrie à partir de composants logiciels et d’infrastructure, en les enrichissant de métadonnées contextuelles et en les analysant par le biais de tableaux de bord, d’alertes ou de systèmes automatisés. Ce processus permet aux équipes de comprendre la santé du système, de détecter les anomalies, de corréler les événements et de résoudre les problèmes plus rapidement. Plus la télémétrie est riche et structurée, plus l’observabilité est efficace.

Dit-on observance ou observabilité ?

L’observance désigne le respect et la pratique de règles et n’a rien à voir avec l’observabilité.

Pages linked on this

Découvrez comment Centreon va transformer votre business

Restez informés sur notre actualité